Анализ на съгласуваност на експертни оценки (категорийни данни)

Двама или повече оператори оценяват визуално определен брой обекти. Представлява интерес доколко съвпадат оценките на операторите. За оценяване на съгласуваността на оценките се използва величината капа (kappa):

където

Po

е

наблюдаваната пропорция на еднаквите оценки, Рe e

очакваната

пропорция на еднаквите оценки. Приети са следните критерии за стойността на

kappa

(![]() ):

):

< 0 - Неслучайно разминаване на оценките

< 0.4 - Лошо съгласуване на оценките

< 0.7 - Измервателната система не е добра

0.7 – 0.9 - Добро съгласуване на оценките

> 0.9 - Отлична измервателна система

В тази задача има два варианта. Единият е когато оценителите класифицират всеки от обектите в една от две категории (годно, негодно), а вторият е когато те ги подреждат в групи в съответствие с някаква скала (1,2,3 4 и т.н.).

Първи вариант (анализ на измервателна система с атрибути). В този случай всички обекти се отнасят към една от две категории. В тази програма резултатите могат да се записват с думи или цифри, например:

ОK или NOK, Да или Не, Годно или Негодно, Go или No Go, Pass или Fail, 1 или 0

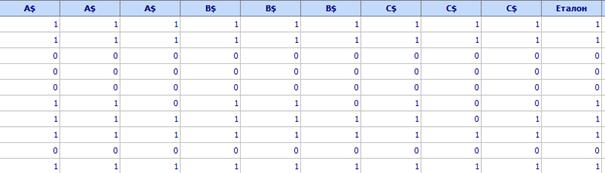

Пример. Трима оценители A,B и C оценяват 50 детайла, като ги отнасят към една от категориите Годно (1) или Негодно (0). Всеки извършва оценяването по 3 пъти без да знае, че това са едни и същи детайли. За тези 50 детайла се знае и истинското им състояние, което е означено като „Еталон“ (не е задължително да се задава „Еталон“). Фрагмент от таблицата с данните е показан по-долу:

Съблюдават се следните правила:

1. Данните от всеки опит (в примера: първи, втори или трети) на даден оператор се записват в отделна колона

2. Името на всички колони за един и същи оператор е еднакво (например А$ или

B$ или C$). Знакът $ означава, че колоните с еднакви имена се разглеждат от програмата като една обща колона

3. Данните за Еталона се записват еднократно в отделна колона.

Резултатите от изчисленията показват следното:

Втори вариант (дискретни данни с подредени категории). Когато дискретните данни са с 3 или повече подредени категории (ранжирани) за оценяване на измервателната система също може да се използва kappa.

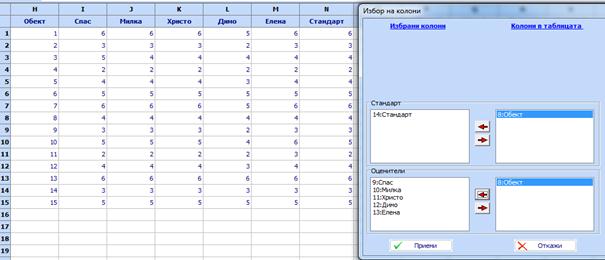

Пример. Разглеждаме случай в който 5 експерта: Спас, Милка, Христо, Димо и Елена визуално оценяват качеството на детайлите. Искаме да проверим дали различните оценители ранжират 15 детайла по един и същи начин. Експертите дават оценки на качеството както следва:

• Лошо = 2

• Средно = 3

• Добро = 4

• Много добро = 5

• Отлично = 6

Всеки експерт оценява по един път всеки детайл. Данните са показани по-долу:

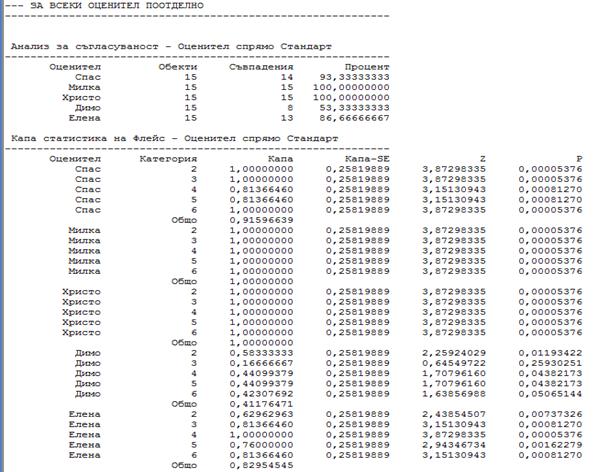

Получават се следните резултати:

Най-добро съвпадение със стандарта показват оценките на Милка и Христо (100 %), следва Спас (93.3 %), Елена (86.7 %), Димо (53.3 %). Съвпадението на оценките на Милка и Христо е отлично (Kaпa =1), на Спас – между отлично и много добро (Kaпa = 0,916), на Елена е добро (Kaпa = 0.83), a на Димо не е добро (Kaпa=0.41).

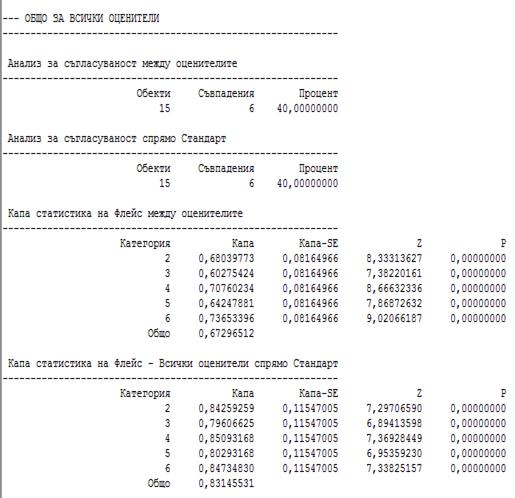

Изчисленията дават и следната информация за всички оценители взети заедно:

Съгласуваността на оценките за всички оценители помежду им не е добра (Kaпa = 0.673). Най-голями различия има при оценката 3 (за нея Kaпa = 0.603). Общото съвпадение на всички оценки със стандарта е добро (Kaпa = 0.83).